آزمونی که GPT-4 را به زانو درآورد !

فرانسوا شوله با طراحی آزمون ARC-AGI ثابت کرد که مدلهای هوش مصنوعی فعلی مانند GPT-4 فاقد هوش سیال انسانی هستند و تنها با تقلید از دادهها عمل میکنند.

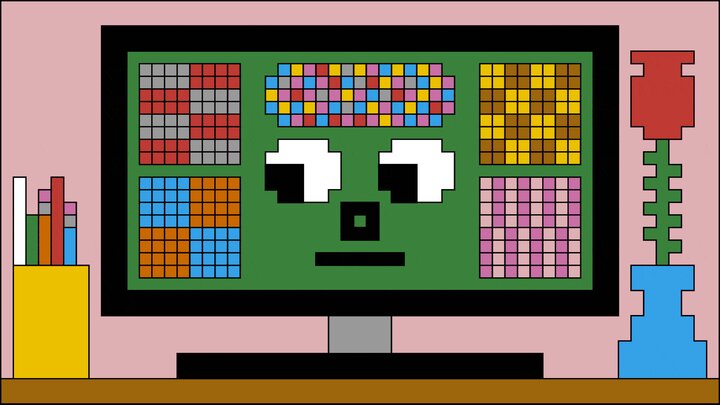

به گزارش سبک ایده آل، فرانسوا شوله، دانشمند فرانسوی و منتقد سرسخت فناوری هوش مصنوعی، با طراحی آزمون ARC-AGI نشان داد که مدلهای هوش مصنوعی مانند ChatGPT تنها با تقلید از دادههای آموزشی عملکرد خوبی دارند و فاقد توانایی حل مسائل از اصول اولیه هستند. در این آزمون، هوش مصنوعی باید توانایی حل مسائل جدید را بدون تکیه بر دانش قبلی نشان دهد.

مدلهای پیشرفتهای مانند GPT-4، Gemini 1.5 و Claude 3 در نسخه اول این آزمون نمرات پایینی (بین ۰ تا ۱۴ درصد) کسب کردند، در حالی که انسانها بهطور متوسط ۶۰ تا ۷۰ درصد امتیاز میگیرند. حتی GPT-4o که به استدلال پیشرفته معروف بود، تنها ۵ درصد موفقیت داشت!

با این حال، OpenAI مدل o3 را معرفی کرد که با کسب ۸۷ درصد در این آزمون برای اولین بار به سطح انسان رسید. این پیشرفت شوله را شگفتزده کرد، اما او همچنان معتقد است که این مدلها با استفاده از هزینههای محاسباتی بالا به نتیجه میرسند، نه با هوش سیال واقعی.

نسخه دشوارتر این آزمون، ARC-AGI-2، عملکرد مدلها را به شدت کاهش داد و مدل o3 از ۸۷٪ به زیر ۲٪ سقوط کرد. این نتایج دوباره سوالات زیادی را در مورد تواناییهای واقعی هوش مصنوعی ایجاد کرد.

موافقان این پیشرفتها معتقدند که o3 گامی به سوی هوش مصنوعی عمومی (AGI) است، اما منتقدان مانند شوله بر این باورند که این مدلها با محاسبات انبوه موفق میشوند و نه با استدلال انسانی. شوله تأکید میکند که تا زمانی که مدلها نتوانند مسائل جدید را مانند یک کودک از صفر یاد بگیرند، ادعای دستیابی به AGI تنها یک فریب بازاریابی است.